O moderno Conheça seu cliente Os sistemas (KYC) aproveitam tecnologias avançadas para fornecer onboarding remoto aos clientes. No processo, normalmente um usuário apresenta um documento de identificação e depois tira uma selfie. Algoritmos sofisticados então cruzam a foto no documento de identificação com a selfie para autenticar a identidade do usuário. Este método simplificou o processo KYC, permitindo que as empresas fizessem o onboarding de clientes remotamente sem sacrificar a integridade e a segurança dos seus sistemas.

No entanto, ataques de apresentação são uma forma comum de os fraudadores manipularem esse processo. Esses ataques envolvem a apresentação de um objeto ou mídia falsificado ou manipulado a um sensor biométrico. No caso de sistemas KYC remotos, isso pode envolver o uso de uma foto ou vídeo no lugar de uma selfie ao vivo. Este tipo de fraude tem sido amplamente explorado, o que levou ao desenvolvimento de novos padrões, como ISO/IEC 30107. Este padrão fornece métodos para testar a capacidade da tecnologia biométrica de resistir a ataques de apresentação e ainda fornece certificação com níveis 1-2 de organizações como iBeta Quality Assurance Lab. Essa certificação valida que uma determinada solução de Presentation Attack Detection (PAD) fornece o nível necessário de proteção contra ataques de apresentação.

Apesar destas medidas de proteção, a indústria da identidade digital enfrenta agora um novo tipo de ataque denominado ataque de injeção. Nesse cenário, uma imagem ou vídeo não é apresentado à câmera, mas sim injetado usando uma câmera virtual, um dispositivo USB de hardware ou até mesmo um código JavaScript que sequestra o fluxo de vídeo da câmera. A imagem a seguir demonstra como um capturador USB externo pode ser usado para injeção.

Para o sistema operacional, um capturador USB padrão aparece como uma câmera USB normal. No entanto, o fluxo de vídeo não se origina da lente de uma câmera, mas da tela de um laptop Source, refletido e capturado pelo dispositivo USB. Isso pode ser conseguido com uma função simples de extensão de tela ativada conectando um cabo USB-C a um laptop. Ao abrir qualquer foto/vídeo na tela do laptop Source, ele será transmitido como um vídeo supostamente vindo da câmera USB. Tanto o sistema operacional quanto o aplicativo executado no laptop Sink não conseguem reconhecer que o fluxo de vídeo não vem da lente da câmera, tornando esse um truque de baixo custo, mas eficaz para os fraudadores.

Como esse tipo de injeção pode ser detectado e prevenido?

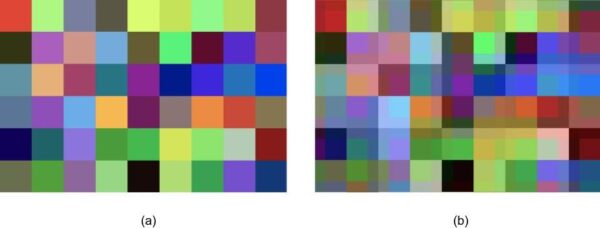

É aqui que entra a Inteligência Artificial (IA). Curiosamente, o fluxo de vídeo que passa do monitor para o capturador USB é recomprimido duas vezes. Primeiramente, isso ocorre quando o sinal de vídeo original é arquivado no disco rígido do Laptop Fonte. Posteriormente, apesar da alta resolução do formato de vídeo original, ele acumula artefatos devido à recompressão quando transferido através do USB Capturer. Esses artefatos são um subproduto dos algoritmos de compressão que se esforçam para minimizar o tamanho dos dados de vídeo ou convertê-los de um formato para outro, muitas vezes resultando na perda de detalhes da imagem. Essas alterações podem se manifestar como imagens borradas ou em blocos, faixas coloridas ou efeitos de manchas.

Figura. Uma pequena área da imagem original (a) e recomprimido (b).

Esses artefatos são normalmente invisíveis ao olho humano, mas podem ser detectados por IA especificamente treinada para esse fim. Assim como uma rede neural pode ser treinada para reconhecer objetos, rostos e ataques de apresentação, ela também pode distinguir entre imagens provenientes de uma câmera real e aquelas injetadas por meio de um capturador USB ou câmera virtual. Esses métodos de injeção normalmente envolvem processos mais complexos e, portanto, resultam em mais perdas durante a transmissão do sinal de vídeo, fornecendo uma base para detecção.

Treinar uma rede neural artificial para realizar esta tarefa normalmente requer um volume significativo de amostras. Por exemplo, 10.000 a 100.000 amostras podem ser suficientes para treinar um Produto Mínimo Viável (MVP) de uma rede neural baseada em camadas convolucionais. Para um detector mais preciso e robusto, podem ser necessárias entre 100.000 e 1 milhão de amostras. Para aplicações comerciais que exigem alta precisão, podem ser necessárias cerca de 1 milhão de amostras.

Ao investir nessas soluções de IA , os processos de verificação de identidade digital podem combater melhor a ameaça crescente de ataques de injeção, aumentando a segurança geral do onboarding remoto e de outros processos de identificação digital.